ChatGPT, Google Bard, Bing Chat, Claude und Co. werden als KI-Bots im Digitalraum immer prominenter. Dabei greifen die Bots auf zahlreiche Websites zu, um den Usern passende Inhalte für die Konversation und etwaige Fragen liefern zu können. Erst kürzlich hat OpenAI für ChatGPT das Web Browsing Feature ausgerollt. ChatGPT kann dank der Funktion beim Web Browsing direkt Seiten anklicken und besuchen. Seitenbesitzer:innen können aber einstellen, ob sie den Zugriff durch den Bot zulassen. Denn im Rahmen des Updates muss ChatGPT auch robots.txt-Vorgaben folgen. Und OpenAI – das im August 2023 den eigenen GPTBot als Crawler vorstellte – muss bereits damit auseinandersetzen, dass viele Publisher den Zugriff des KI-Unternehmens ablehnen, womöglich, damit ihre teils auch exklusiven Inhalte nicht einfach von einer KI gescrapt werden.

Mit dieser Thematik beschäftigt sich auch Google. Das Unternehmen liefert Publishern jetzt eine neue Kontrollmöglichkeit, die ihnen mehr Möglichkeiten zur Verwaltung der Zugriffe durch Bard und generative APIs der Vertex AI-Plattform bietet.

Google verwendet positiv konnotierte Formulierung: Hilfe für Bard und Co. leisten oder nicht?

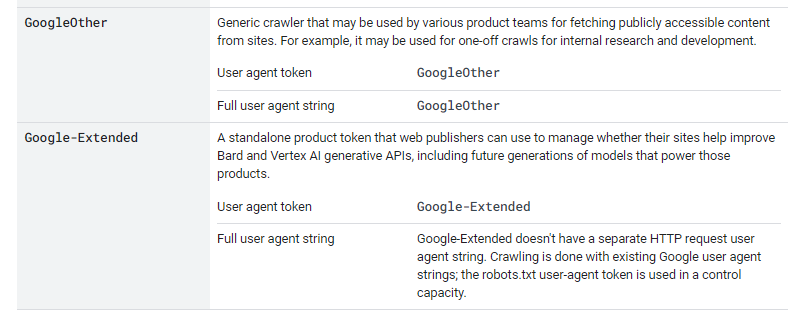

Auf dem Google Blog The Keyword erklärt Danielle Romain, VP of Trust beim Unternehmen, dass die neue Option Google-Extended als Publisher-Kontrolle bereitsteht. Die englischsprachige Dokumentationsseite für die Crwaler und Fetcher von Google (also User Agents) führt Google-Extended in einer Reihe mit dem GoogleBot Smartphone, dem Google StoreBot und Co. bereits auf. Auf der deutschsprachigen Seite ist das Element noch nicht verfügbar. Die Option zählt zu den Common Crawlern und muss den Vorgaben durch robots.txt folgen.

Das Wording, dass Danielle Romain verwendet, lässt darauf schließen, dass Google möglichst viele Publisher dazu ermutigen möchte, den Zugriff von Bard und auch künftigen AI-Systemen nicht zu verwehren. So schreibt sie, Publisher könnten entscheiden, ob sie die KI-Systeme dabei unterstützen wollten, genauer und leistungsfähiger zu werden. Auf X stellt der User und SEO-Spezialist Yiğit Konur in diesem Kontext die Frage, ob sich Publisher, die den Zugriff erlauben, auch auf eine verlässliche Quellenanführung freuen können.

Will companies that have given permission to show the results be referenced properly in responses by Bard or SGE? So do we promise an incentive for traffic?

And will you remove sites that do not allow it from PaLM's data?

I guess it is not clear yet but I wanted to ask anyway

— Yiğit Konur (@yigitkonur) September 29, 2023

Danielle Romain schreibt auf dem Google Blog, dass es ein wichtiger Schritt für die Transparenz im Rahmen des Crawlings vonseiten Googles ist, Kontrollen über robots.txt bereitzustellen. Zugleich möchte Google aber noch andere Kontrollsysteme ausloten, die der KI-Entwicklung eher gerecht werden:

Making simple and scalable controls, like Google-Extended, available through robots.txt is an important step in providing transparency and control that we believe all providers of AI models should make available. However, as AI applications expand, web publishers will face the increasing complexity of managing different uses at scale. That’s why we’re committed to engaging with the web and AI communities to explore additional machine-readable approaches to choice and control for web publishers

Schon im Juli bestätigte Google, Alternativen für den rund 30 Jahre alten Quasi-Standard robots.txt ausloten zu wollen.

Auch wegen AI-Aufschwung:

Google sondiert Alternativen zu robots.txt

© Christian Wiediger – Unsplash